Shadow AI: 80% сотрудников используют ИИ-сервисы в обход корпоративных правил

Использование сотрудниками любых ИИ‑инструментов (чаще всего генеративных моделей, чат‑ботов, внешних API) без официального одобрения, учёта и контроля со стороны ИТ‑ и служб безопасности компании.

Теневая сторона продуктивности

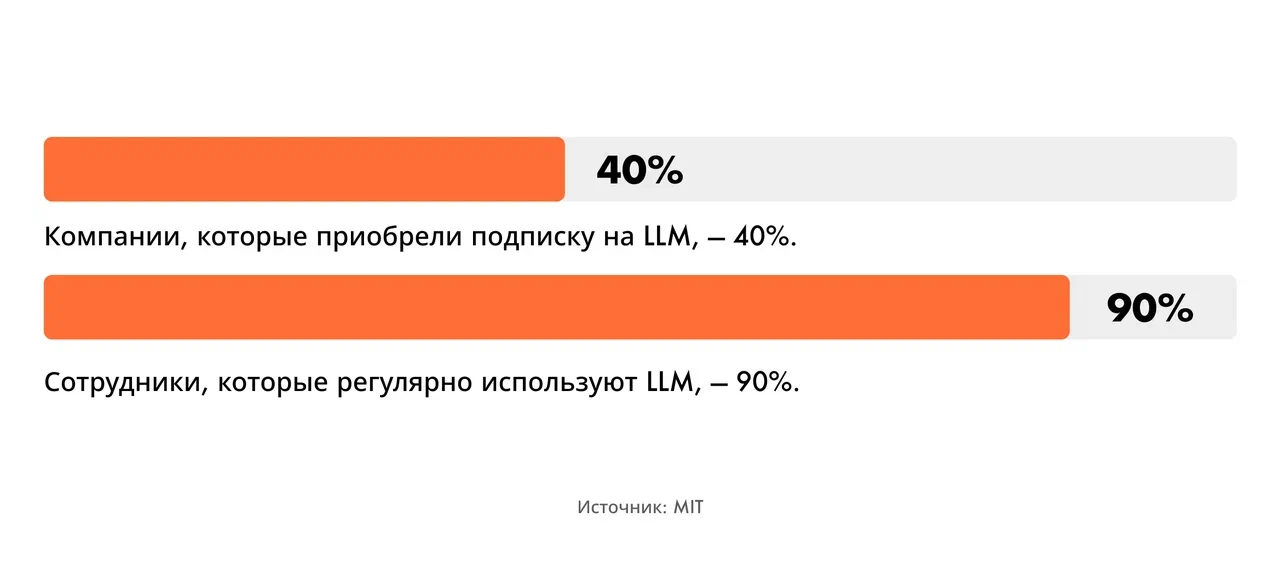

По данным исследования Massachusetts Institute of Technology, лишь 40% компаний заявляют, что приобрели официальную подписку на LLM, при этом сотрудники более 90% компаний-участников опроса сообщили о регулярном использовании персональных инструментов для решения рабочих задач.

Источник: MIT

Чаще всего Shadow AI используют сотрудники малого и среднего бизнеса. Из-за ограниченного ИТ-штата и специалистов по безопасности такие компании попадают в идеальный шторм: быстрое внедрение ИИ без достаточных ресурсов и времени, чтобы взять теневые инструменты под контроль.

В России, по данным hh.ru, 26% сотрудников регулярно используют ИИ-инструменты, 35% — периодически. Он помогает ускорять выполнение задач (так ответили 67% опрошенных), экономить рабочее время (63%) и качественнее выполнять обязанности (33%). Однако нередко использование ИИ происходит спонтанно и без какого-либо контроля со стороны ИТ и служб ИБ.

Источник: IT World

А в чём проблема?

Эксперты ИБ-рынка называют теневой ИИ растущей угрозой. Искусственный интеллект для безопасников — это второй Shadow IT, считают эксперты ГК «Солар». В нейросети загружается большой объем данных с корпоративных систем государственных и коммерческих организаций. Это могут быть файлы, содержащие как общеизвестную информацию о компании, так и чувствительные данные: например, чертежи оборудования с подробными расчетами или закрытые финансовые показатели.

«Случай из практики, от которого у любого профессионала по безопасности пробегает холодок по спине: полковник одного из государственных ведомств использует ChatGPT для оптимизации расстановки сил и средств. Секретные актуальные данные загружаются в публичный чат-бот. Аргумент обезоруживающе прост: «Так быстрее. Нейросеть за минуту всё сделала», — рассказал генеральный директор ООО «Альянс перспективных технологий» Ильдар Саттаров.

Проблема в том, что все ИИ-инструменты, за исключением внедрённых самой компанией, обрабатывают данные на внешних, чаще всего иностранных, серверах. При этом сотрудники могут передавать ИИ конфиденциальную информацию, не задумываясь о последствиях, говорит директор по развитию бизнеса компании «Информзащита» Андрей Тимошенко. Shadow AI создают огромные «слепые зоны», которые традиционные решения по безопасности не способны охватить.

Теневые инструменты могут незаметно «жить» в инфраструктуре компании очень долго, иногда больше года. За это время они успевают обработать массу чувствительных данных. Кроме того, ИИ-инструменты так глубоко врастают в бизнес-процессы, что отключить их без сбоев в работе и недовольства пользователей почти невозможно. В результате у компаний растут необработанные риски (утечки, нарушения комплаенса и уязвимости), закрыть которые становится чем дальше, тем сложнее и дороже. Всего в 2025 году инциденты, связанные с теневым ИИ, составили около 20% всех утечек данных в мире, то есть примерно каждая пятая утечка была связана именно с Shadow AI.

Игнорирование Shadow AI — не просто гипотетический риск, оно имеет вполне конкретную цену. В 2025 году утечки в организациях с высоким уровнем теневого AI в среднем обходились на $670 тыс. дороже, чем другие инциденты компрометации данных.

Самые опасные ИИ-сервисы

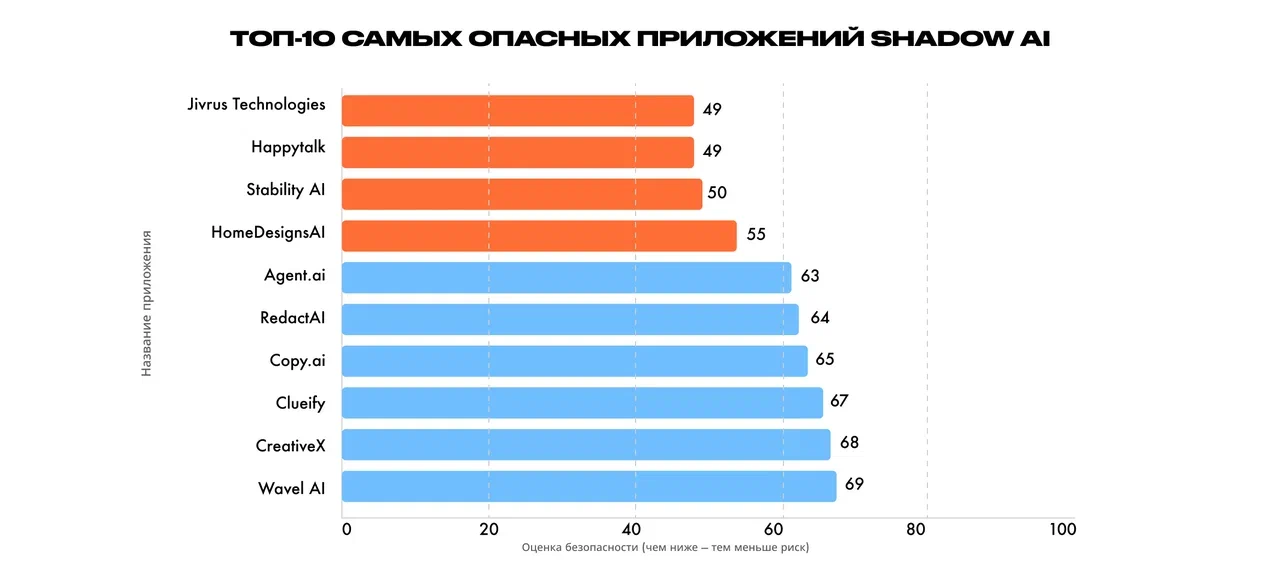

Reco выделила топ-10 опасных теневых ИИ-приложений, которые наиболее распространены в компаниях. Каждому из них поставлены баллы от 1 до 100 (чем ниже балл, тем меньше уровень безопасности). Методология оценки включала ключевые индикаторы риска: стойкость шифрования, механизмы аутентификации, практики обработки данных и соблюдение регуляторных требований.

Источник: Reco

Исследователи также сообщают, что абсолютный лидер теневого использования — ChatGPT. На него приходится 53% всего несанкционированного использования AI в корпоративной среде в мире. Такая масштабная концентрация активности на одной платформе создаёт как операционные зависимости, так и серьёзные риски для безопасности, считают эксперты Reco.

Работают ли запреты

Большинство зарубежных организаций, в которых произошли инциденты безопасности (63%), либо не имеют политики управления ИИ, либо всё ещё находятся в процессе её разработки. Впрочем, даже среди тех, у кого такая политика если, лишь 34% регулярно проводят аудит на предмет несанкционированного использования ИИ. По оценкам российских экспертов, регулированием использования ИИ-инструментов в корпоративной сети отечественные компании также пока занимаются слабо.

«Крупные предприятия стараются управлять процессом, оплачивая enterprise-версии ИИ-инструментов (например, ChatGPT Enterprise или Microsoft Copilot), в которых галочка «обучение на данных пользователя» отключена юридически. То есть данные не покидают периметр компании. Многие рекомендуют применять определенные ИИ-инструменты только для выполнения конкретных задач. Есть и те, кто запрещает своим сотрудникам использовать ИИ-решения, но обычно это не имеет нужного эффекта», — говорит управляющий RTM Group, эксперт в области кибербезопасности и права в ИТ Евгений Царев.

В банках, например, блокируют доступ к доменам OpenAI, Midjourney и др. на уровне корпоративного прокси. Но это никак не защищает от того, что персонал открывает тот же ChatGPT на личном смартфоне, перепечатывает и фотографирует данные компаний, отмечает эксперт.

«Запреты не работают. В результате компании неизбежно придут к формату BYOAI (Bring Your Own AI). То есть бизнесу придется создавать изолированные «песочницы», где сотрудники смогут легально использовать свои любимые инструменты, но без риска слить коммерческую тайну», — считает основатель исследовательского проекта Digital Society Lab Максим Минкин. Shadow AI превратится в управляемую инновацию — сотрудники предлагают, компания быстро проверяет и внедряет, также считает партнер ООО «Киберсистема» Иван Ануфриев. Компании, которые сейчас вводят жесткие запреты для работников на использование ИИ, рискуют оказаться неконкурентоспособными.

Компании могут использовать комплекс решений на базе DLP- и прокси-систем, чтобы безопасно внедрять ИИ в свою операционную деятельность, считают в ГК «Солар». Например, DLP-система «Солара» занимается мониторингом рабочих станций и предотвращает утечку данных во всех каналах передачи информации (в корпоративной почте или мессенджерах). Solar webProxy может предотвратить утечку чувствительной информации в нейросети на уровне контентной фильтрации трафика и, наоборот, вторжения с помощью ИИ в сеть.

«В будущем можем увидеть, что ИИ-технологии будут повсеместно использоваться в продуктах по информационной безопасности для автоматизации процессов и отражения кибератак. Это связано с тем, что злоумышленники уже используют различные ИИ-инструменты для вторжения в инфраструктуру. Таким образом, ИИ будет против самого себя», — рассказали в пресс-службе ГК «Солар».

Чек-лист: как контролировать ИИ

- Обнаружение и инвентаризация: внедряйте инструменты для выявления и каталогизации ИИ-приложений внутри организации, чтобы получить видимость по паттернам использования и потенциальным уязвимостям.

- Оценка рисков: исследуйте каждый обнаруженный ИИ-сервис или инструмент, чтобы понять его потенциальное влияние на безопасность, соответствие требованиям, конфиденциальность данных и бизнес-операции.

- Разработка политик: установите чёткие правила, которые определяют допустимое использование ИИ, утверждённые инструменты и ожидания по безопасности.

- Обучение сотрудников: регулярно информируйте сотрудников о рисках, связанных с ИИ, обязанностях по соблюдению требований и лучших практиках.

- Мониторьте ИИ-агентов и распространение NHI: внедрите меры контроля, предназначенные специально для агентов, включая ротацию учётных данных, проверки доступа и мониторинг активности.